2610 篇

1069 篇

240053 篇

3269 篇

7548 篇

2220 篇

2770 篇

532 篇

37516 篇

9341 篇

3134 篇

745 篇

2291 篇

1315 篇

449 篇

752 篇

1387 篇

2596 篇

2739 篇

3982 篇

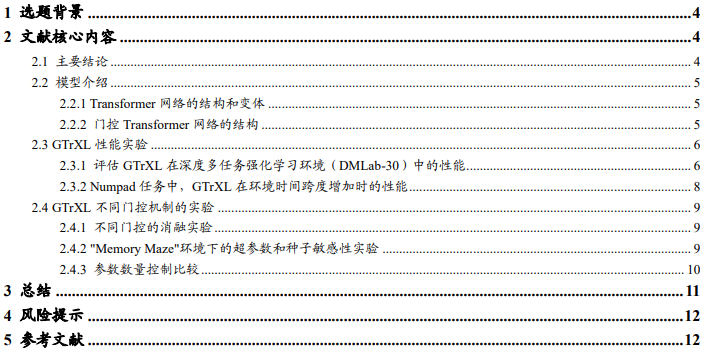

引入门控机制的Transformer模型探究-学界纵横系列之三

在时序依赖的任务中(如 RL),基于 RNN 的模型性能和稳定性优于 Transformer 架构。然而,Transformer 中的自注意力机制能够长时间跨度上有效整合信息并扩展到大量数据。为了提升时序依赖任务场景中的模型表现,在 Transformer-XL 基础上提出的 Gated Transformer-XL(GTrXL),该模型架构在稳定和性能上持平甚至赶超 LSTM 模型。