2623 篇

1085 篇

194535 篇

3304 篇

6315 篇

2230 篇

2779 篇

537 篇

29607 篇

9651 篇

3153 篇

755 篇

2298 篇

1317 篇

449 篇

752 篇

1387 篇

2603 篇

2737 篇

3998 篇

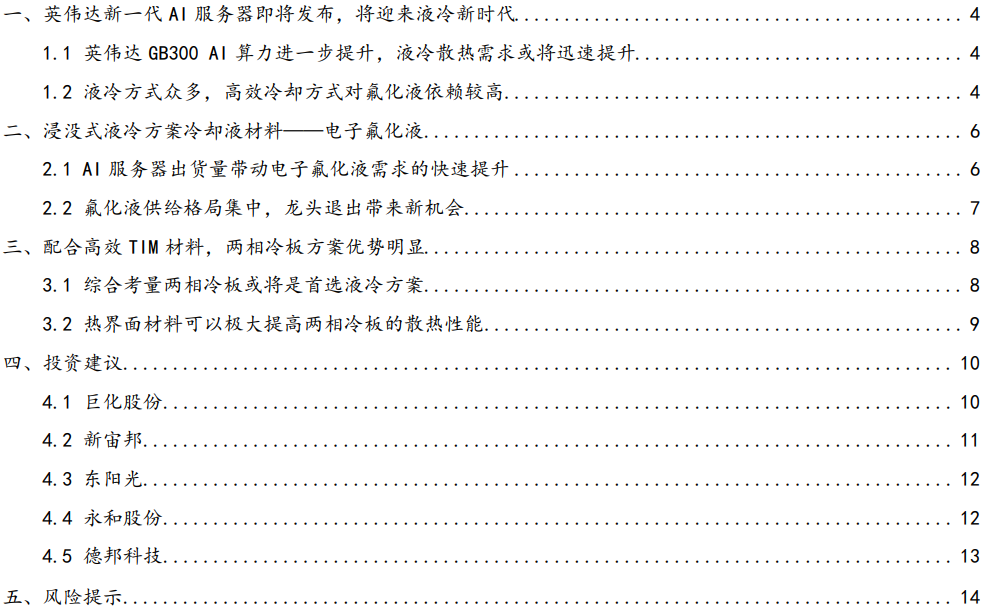

AI服务器散热进入液冷时代,导热散热材料需求突显——AI系列深度(五)

英伟达 GB300 NVL72 服务器算力进一步提升,液冷散热需求迅速提升。英伟达今年即将发布其专为 AI 推理时代而打 造的 AI 服务器 NVIDIA DGX GB300 NVL72,AI 算力进一步提升,推论效能较 DGX GB200 提升了 1.5 倍。超高的芯片运算能力使得热设计功耗(TDP)进一步提升,传统风冷散热技术热导率较低,难以满足较高 TDP 的散热需求,GB300 服务器采用了完全液冷式机架设计,引领了 AI 服务器液冷的新潮流。AI 服务器液冷散热需求或将伴随 AI 服务器出货量的提升而迅速提升。